Jakob Schreiber, Shu Ching Chon

Klangklotz-Studie

Virtual-Reality-Performance

Die Studie lotet die Möglichkeiten der virtuellen Umgebung zum zeitlichen und räumlichen Arrangieren von Klängen aus. Durch die VR-Brille taucht die Performerin in die virtuelle Welt ein. Das Publikum kann über die Projektion ihren Blick nachverfolgen. Sie hat die Möglichkeit, virtuelle Würfel, die Klänge repräsentieren, frei im Raum anzuordnen. Durch das Zeichnen von geschlossenen Bahnen mit einem Controller können die 'Klangklötze' zeitlich angeordnet und zu Loops verbunden werden.

Der Fokus der Performance, die am 17. Januar 2020 im Rahmen des Institutsabend des IMWI statt fand, lag auf der Gestaltung einer Klangskulptur. Die meisten der Klänge entstammten Field-Recordings und wurden im Vorfeld editiert.

Entstanden im Rahmen der Lehrveranstaltung Creative Coding: Virtual Reality.

Betreut durch Patrick Borgeat.

Das Projekt wurde auf der 33rd Conference on Neural Information Processing Systems (NeuRIPS 2019) in Vancouver mit dem NeuRIPS-Award for Outstanding Demonstration ausgezeichnet.

Als künstlerisches Entwicklungsvorhaben wurde es mit einem Stipendium nach dem Landesgraduiertenförderungsgesetz unterstützt.

Vincent Hermann

Immersions

Wie klingt Musik in künstlichen Ohren?

In den letzten Jahren lässt sich eine rasant zunehmende Präsenz von Künstlicher Intelligenz, insbesondere in Form von neuronalen Netzen und sogenanntem Deep Learning, im Bereich der Musik- und Klangverarbeitung feststellen: Google generiert so die Stimme des Sprachassistenten, Spotify wertet Millionen Songs aus um sie zu automatisch personalisierten Playlists zusammenzustellen, inzwischen komponieren künstliche neuronale Netze sogar Popsongs und Filmmusik.

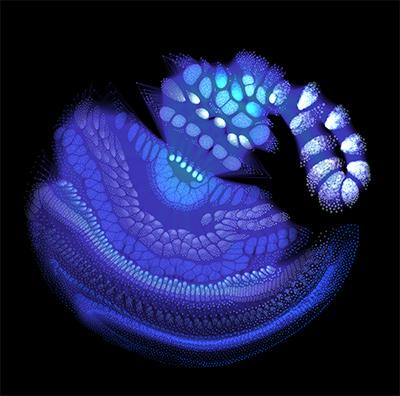

Oft ist es selbst für Experten schwierig zu erkennen, was genau in diesen komplexen selbstlernenden Systemen vor sich geht und wie sie zu diesen bemerkenswerten Ergebnissen kommen. Mit dem Projekt "Immersions" wird das Innere von klangverarbeitenden Netzen hörbar gemacht. Die Grundidee ist im Wesentlichen folgende: Man geht von einem beliebigen Klangschnipsel aus (z.B. einem Drum-Loop). Dieser wird durch ein Optimierungsverfahren so verändert, dass er einen bestimmten Bereich im neuronalen Netz besonders aktiviert. Der veränderte Clip kann dann als Basis für eine neue Optimierung mit einem anderen Bereich im Netz als Kriterium verwendet werden. So erhält man Klänge, die das neuronale Netz frei assoziativ generiert. Gleichzeitig werden die Vorgänge im Netzwerk visualisiert, sodass man dem System bei der Informationsverarbeitung zusehen kann.

Eine der wichtigsten Eigenschaften von neuronalen Netzen ist, dass sie Informationen in verschiedenen Abstraktionsgraden verarbeiten. Entsprechend kann eine Aktivierung in einem bestimmten Bereich des Netzes zum Beispiel mit einfachen kurzen Tönen oder Geräuschen einhergehen, in einem anderen Bereich mit komplexeren musikalischen Phänomenen wie Phrase, Rhythmus oder Tonart. Worauf genau ein neuronales Netz "hört", hängt sowohl von den Daten ab, anhand derer es gelernt hat, als auch von der Aufgabe, für die es spezialisiert ist. Das heißt, für unterschiedliche Netze klingt Musik auch unterschiedlich.

Um all das direkt erfahrbar zu machen habe ich ein Setup entwickelt, mit dem die Generierung und Steuerung der Klänge in Echtzeit möglich ist. Als Material für die Live-Performance dienen dann nicht Songs oder vorprogrammierte Loops, sondern Halluzinationen neuronaler Netze.

Eigenständiges Studienprojekt.

Unterstützt von Prof. Dr. Christoph Seibert.

Alexander Lunt

MODI

für gestisches Interface und Performer

MODI ist das künstlerische Ergebnis der Master Arbeit von Alexander Lunt, uraufgeführt im November 2018. Es werden verschiedene Arten der kontaktlosen Interaktion zwischen Mensch und Maschine aufgeführt. Beispielsweise wird in einigen Modi der Körper als Instrument betrachtet, in anderen wiederum als Controller. Dabei ist die Verklanglichung der Bewegungen der Hände die Grundidee. Technisch wurde das Projekt mit hochauflösenden Motion-Capture-Kameras und Max realisiert.

Entstanden im Rahmen der Masterarbeit von Alexander Lunt.

Betreut durch Prof. Dr. Marc Bangert und Prof. Dr. Thomas A. Troge.

Das Projekt wurde auf der 8th Conference on Computation, Communication, Aesthetics & X (xCoAx 2020) vorgestellt.

Jia Liu

Ringstudie II/b

Live-Performance mit einem autonomen Pitch-Following Feedback-System

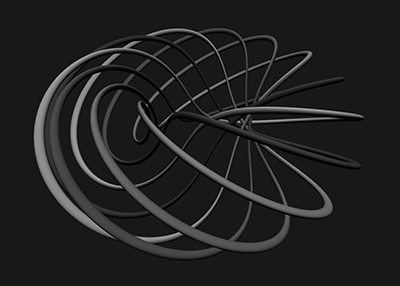

Ringstudie II/b ist eine Live-Coding Performance für 3D-Lautsprecher-Setups realisiert in SuperCollider. Sie besteht aus bis zu 64 diskreten Audiokanälen, die jeweils den Output eines Sinus-Oszillators abspielen, der jeweils der Frequenz eines anderen Kanals oder sich selbst folgt. Mit einem von der Knoten- und Graphentheorie inspirierten Ansatz werden Verknüpfungen und Neuverknüpfungen zwischen Kanälen durchgeführt, um verschiedene Knoten, Ketten oder Ringe aufzubauen, die eine oder mehrere Rückkopplungsschleifen schließen und ihr eigenes charakteristisches Verhalten erzeugen, das in den menschlichen Hörraum projiziert wird.

Die Performance ist eine Echtzeit-Interaktion mit dem System, hauptsächlich über die Steuerung der Signalfluss-Topologien mittels Verfolgungsstrukturen, der Definition von Verfolgungsregeln sowie durch das Modulieren des Signals (Frequenz Deviationen, Frequenz Modulation), in ständiger Beobachtung des Systemverhaltens durch auditives Feedback.

Die Idee eines autonomen Tonhöhen-Verfolgungssystems entstammt dem “Zwillingsstück” Ringstudie II/a - einer „analogen“ Version für Sänger, die im Kreis angeordnet gegenseitig ihren Tonhöhen folgen. Beide Stücke untersuchen auf eigene Weise, wie Abweichungen und Ungenauigkeiten jedes einzelnen Agenten den Gesamteffekt, das räumliche Verhalten und die zeitliche Entwicklung beeinflussen.

Entstanden im Rahmen der Lehrveranstaltung Kreative Programmieren 3.

Betreut durch Patrick Borgeat und Prof. Dr. Christoph Seibert.

Das Projekt wurde auf der International Computer Music Conference 2019 (ICMC-NYCEMF 2019) in New York City vorgestellt.

Michele Samarotto, Daniel Kurosch Höpfner

Kollaboratives audio-visuelles Live-Coding

Ein graphischer Ansatz zur Dynamischen Wave Terrain Synthese durch Shader-Programmierung

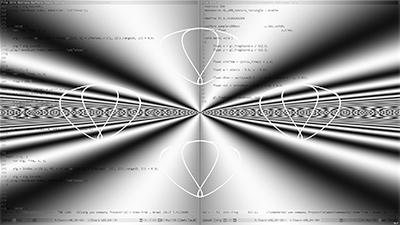

Die Praxis des Live-Codings hat sich als relevanter Ansatz zur Aufführung und Gestaltung elektronischer Computermusik mit einem besonderen Fokus auf die Möglichkeiten und Herausforderungen der Improvisation etabliert. In den meisten kollaborativen Live-Coding Szenarien agieren die Akteure als autonome Instrumentalist*innen. Auf der Suche nach alternativen kollaborativen Aufführungsmodalitäten erkunden wir bestimmte Arten multi-modaler Interdependenzen im Kontext einer audio-visuellen Duo-Performance, durch die individuelle Live Programmierung zweier konstitutiver Bestandteile eines Klangsynthesemodells: Dynamische Wave Terrain Synthese.

Durch die Strukturierung des Synthesemodells in zwei unabhängig voneinander steuerbare Prozesse (Terrain- und Trajektoriengenerierung) mit komplexen Abhängigkeiten, ist die Dynamische Wave Terrain Synthese insbesondere für die Erkundung neuer Arten kollaborativer Interaktion in computer-basierter Musikaufführungspraxis interessant, zumal die Möglichkeit gegeben ist, diese Prozesse von zwei individuellen PerformerInnen steuern zu lassen. Durch eine starke Assoziierung zu visuellen Darstellungen des Syntheseprozesses, ermöglicht Dynamische Wave Terrain Synthese die Verwendung graphischer Ansätze zur Steuerung des Synthesemodells. Somit kann eine inhärente Kopplung zwischen Klang und Bild erzeugt werden, die eine graphische Konzeption von Klang erlaubt und begünstigt. Folgend entwickelten wir ein Performance Framework für eine audio-visuelle Live Coding Performance basierend auf der Visualisierung von Terrain und Trajektorien und begannen Techniken der Computergraphik, im Einzelnen durch den Gebrauch von Shadern, zur Generierung und Transformation der Terrainstrukturen einzusetzen. Auf diese Weise werden sowohl Klang, als auch Bild durch dieselben zugrunde liegenden Algorithmen erzeugt und die Verwendung extramusikalischer Konzepte zur Klangtransformation ermöglicht.

Eigenständiges Studienprojekt.

Betreut durch Patrick Borgeat und Prof. Dr. Christoph Seibert.